一文看懂基于Windows搭建Ollama+Docker+OpenWebUI+DeepSeek-R1大模型环境

本文主要介绍如何在 Windows 环境安装 Ollama 环境,并在 Ollama 环境中部署 DeepSeek 大模型,最终可以在 web ui 中进行访问模型并使用。

安装与配置 Ollama

安装 Ollama

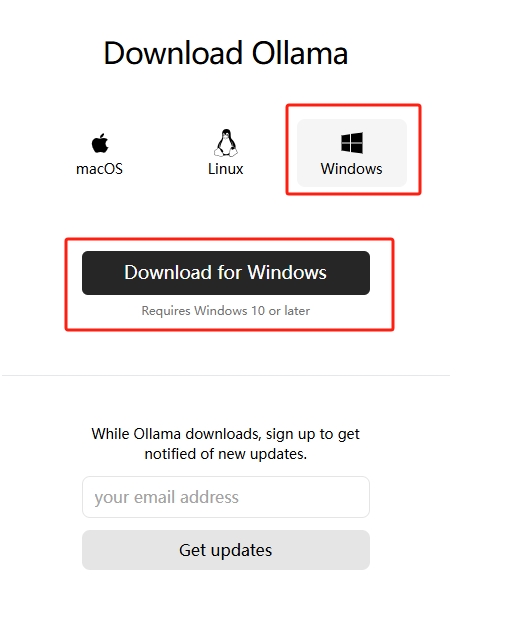

访问 Ollama 官网下载

Ollama 官方 GitHub 源代码仓库:https://github.com/ollama/ollama

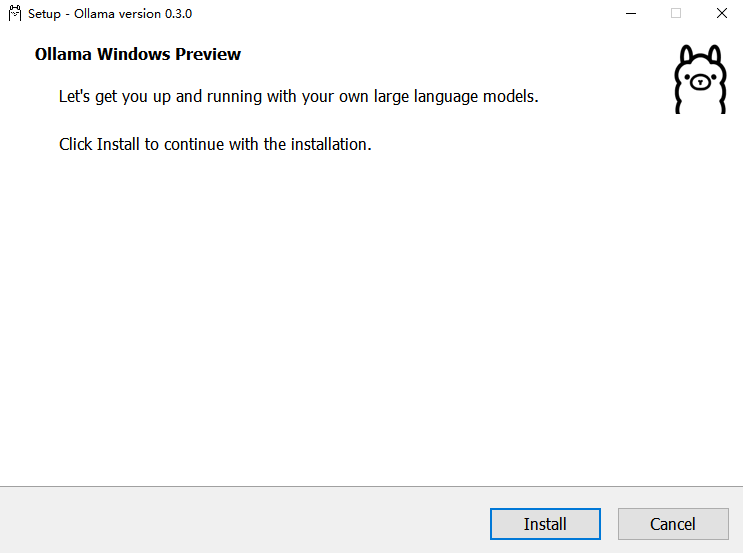

等待 Ollama 下载完成并双击打开下载的文件

OllamaSetup.exe,出现如下弹框,点击Install等待下载完成即可

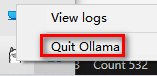

安装完成后,可以看到 Ollama 已经默认自动运行中。可以通过底部的导航栏找到 Ollama 标志。右键 Ollama 图标可以查看运行日志和退出 Ollama。

配置 Ollama

Ollama可以像其他软件一样在电脑上完成一键安装,不同的是,建议按照实际需求配置下系统环境变量参数。以下是 Ollama 的环境变量配置说明。

| 参数 | 标识与配置 |

|---|---|

| OLLAMA_MODELS | 表示模型文件的存放目录,默认目录为当前用户目录即 C:\Users%username%.ollama\modelsWindows 系统 建议不要放在C盘,可放在其他盘(如 E:\ollama\models) |

| OLLAMA_HOST | 表示ollama 服务监听的网络地址,默认为127.0.0.1 如果想要允许其他电脑访问 Ollama(如局域网中的其他电脑),建议设置成 0.0.0.0 |

| OLLAMA_PORT | 表示ollama 服务监听的默认端口,默认为11434 如果端口有冲突,可以修改设置成其他端口(如8080等) |

| OLLAMA_ORIGINS | 表示HTTP 客户端的请求来源,使用半角逗号分隔列表 如果本地使用不受限制,可以设置成星号 * |

| OLLAMA_KEEP_ALIVE | 表示大模型加载到内存中后的存活时间,默认为5m即 5 分钟 (如纯数字300 代表 300 秒,0 代表处理请求响应后立即卸载模型,任何负数则表示一直存活) 建议设置成 24h ,即模型在内存中保持 24 小时,提高访问速度 |

| OLLAMA_NUM_PARALLEL | 表示请求处理的并发数量,默认为1 (即单并发串行处理请求) 建议按照实际需求进行调整 |

| OLLAMA_MAX_QUEUE | 表示请求队列长度,默认值为512 建议按照实际需求进行调整,超过队列长度的请求会被抛弃 |

| OLLAMA_DEBUG | 表示输出 Debug 日志,应用研发阶段可以设置成1 (即输出详细日志信息,便于排查问题) |

| OLLAMA_MAX_LOADED_MODELS | 表示最多同时加载到内存中模型的数量,默认为1 (即只能有 1 个模型在内存中) |

对于初学者,我们强烈建议你配置 OLLAMA_MODELS 来更改模型存储位置。 默认情况下,Ollama 模型会存储在 C 盘用户目录下的 .ollama/models 文件夹,占用 C 盘空间。 将其更改到其他分区可以更好地管理你的存储。

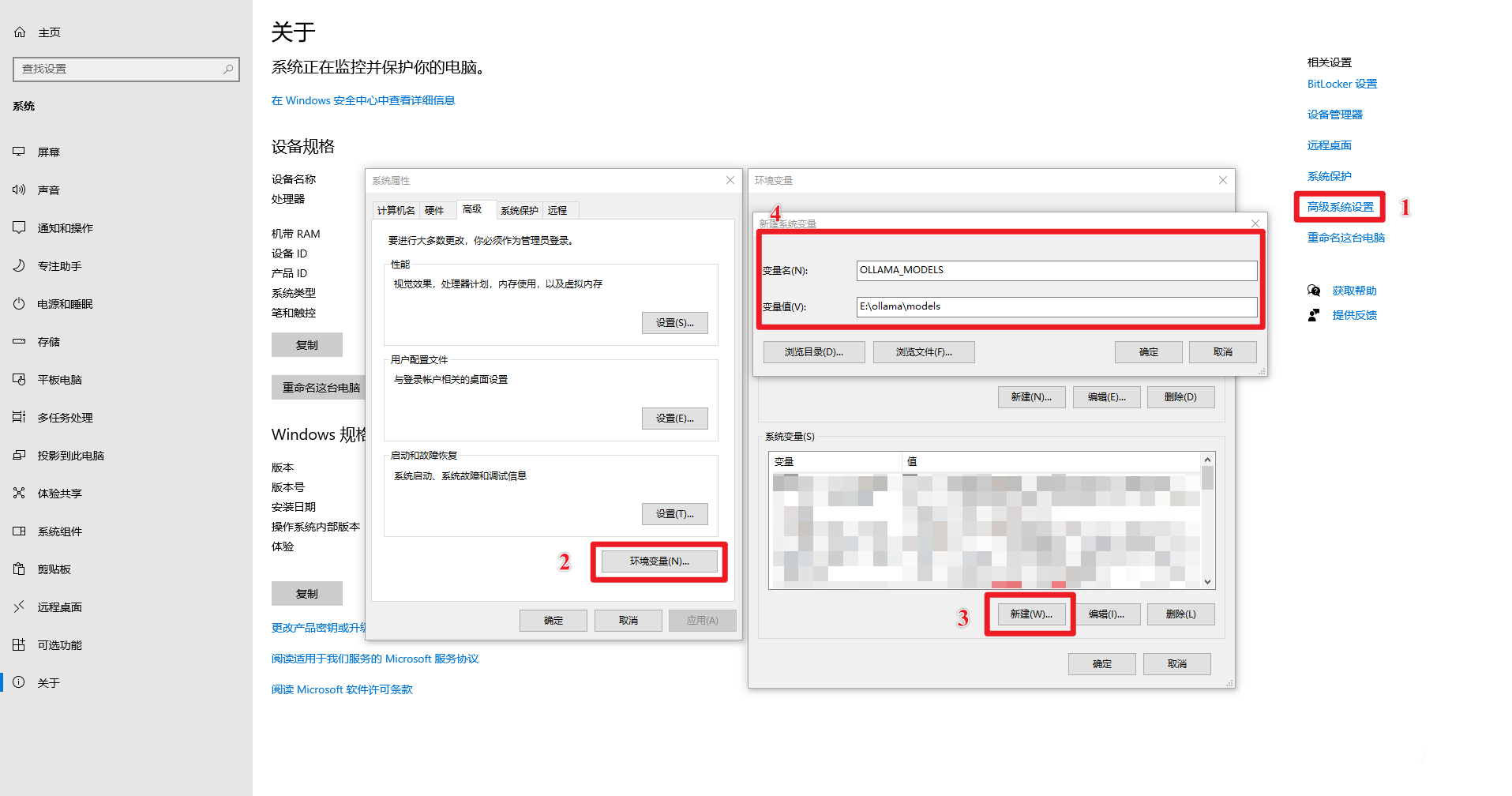

步骤一:找到系统环境变量的设置入口

方法 1:开始->设置->关于->高级系统设置->系统属性->环境变量。

方法 2:此电脑->右键->属性->高级系统设置->环境变量。

方法 3:开始->控制面板->系统和安全->系统->高级系统设置->系统属性->环境变量。

方法 4:Win+R 打开运行窗口,输入 sysdm.cpl,回车打开系统属性,选择高级选项卡,点击环境变量。

步骤 2:设置 OLLAMA_MODELS 环境变量 (更改模型存储位置)

- 在 “环境变量” 窗口的 “系统变量(S)” 区域 (或者 “用户变量(U)” 区域,根据你的需求选择),点击 “新建(W)…” 按钮。

- 在 “变量名(N)” 输入框中,输入:

OLLAMA_MODELS(注意大小写,建议全部大写)。 - 在 “变量值(V)” 输入框中,输入你想要设置的模型存储路径。 例如,如果你想将模型存储到 E 盘的

ollama\models文件夹下,你可以在 “变量值(V)” 中输入:E:\ollama\models(请根据你的实际情况修改盘符和文件夹路径)。- 注意: 请确保你输入的路径是 已经存在的文件夹 或者 你希望创建的文件夹的父目录存在。 Ollama 在首次运行时可能会自动创建

models文件夹,但最好提前创建好ollama文件夹,确保路径的正确性。 - 示例: 为了将模型存储到 E 盘的

ollama\models文件夹,你可以在 “变量值(V)” 中输入:E:\ollama\models

- 注意: 请确保你输入的路径是 已经存在的文件夹 或者 你希望创建的文件夹的父目录存在。 Ollama 在首次运行时可能会自动创建

- 点击 “确定” 按钮,关闭 “新建系统变量” (或者 “新建用户变量”) 窗口。

注意: 如果你不知道如何设置

OLLAMA_MODELS环境变量,可以参考下面的示例。

(可选)设置 OLLAMA_HOST 环境变量 (修改监听地址)

如果你需要让局域网内的其他设备也能访问你的 Ollama 服务,可以配置 OLLAMA_HOST 环境变量。

- 同样在 “环境变量” 窗口的 “系统变量(S)” 区域 (或者 “用户变量(U)” 区域),点击 “新建(W)…” 按钮。

- 在 “变量名(N)” 输入框中,输入:

OLLAMA_HOST - 在 “变量值(V)” 输入框中,输入

0.0.0.0:11434(或者你想要指定的端口号,默认端口是 11434)。0.0.0.0表示监听所有网络接口,允许局域网访问。11434是 Ollama 默认端口。- 示例:

0.0.0.0:11434

- 点击 “确定” 按钮,关闭 “新建系统变量” (或者 “新建用户变量”) 窗口。

步骤 3:重启 Ollama 或 PowerShell 使环境变量生效

环境变量设置完成后,你需要 重启 Ollama 服务 或者 重新启动你的 命令提示符 (CMD) 或 PowerShell 窗口,才能让新的环境变量生效。

- 重启 Ollama 服务: 如果你运行了 ollama serve,先 Ctrl + C 停止,再重新运行 ollama serve。

- 重启命令提示符/PowerShell: 关闭所有已打开的窗口,重新打开新的窗口。

步骤 4:验证环境变量是否生效

- 重新打开 命令提示符 (CMD) 或者 PowerShell。

- 验证 OLLAMA_MODELS: 输入以下命令并回车:

输出:E:\ollama\models (如果你设置的是 E:\ollama\models) |

运行 Ollama

- 命令行语句启动

ollama serve |

启动 Ollama 时会报错如下,因为 Windows 系统安装 Ollama 时会默认开机启动,Ollama 服务默认是 http://127.0.0.1:11434

Error: listen tcp 127.0.0.1:11434: bind: Only one usage of each socket address (protocol/network address/port) is normally permitted.

- 解决方案

- 退出 Ollama

- 在 Windows 任务管理器中结束 ollama.exe 任务

- 在 Windows 下方的导航栏找到 Ollama 图标右键并退出 Ollama

- 启动 Ollama

- 再次在 CMD 命令行中执行

ollama serve命令来再次启动 Ollama - 在 Windows 最近安装找打 Ollama 图标单机启动即可

- 再次在 CMD 命令行中执行

验证安装成功🎉

- 终端输入

ollama -h |

输出如下即表示安装成功🎉

Large language model runner |

安装 DeepSeek-R1 模型

前往 Ollama 模型库 搜索你 DeepSeek-R1 模型,然后直接启动。

ollama run deepseek-r1:7b

下载模型的速度取决网络带宽,下载完成之后即可使用,使用

Control-D退出聊天。

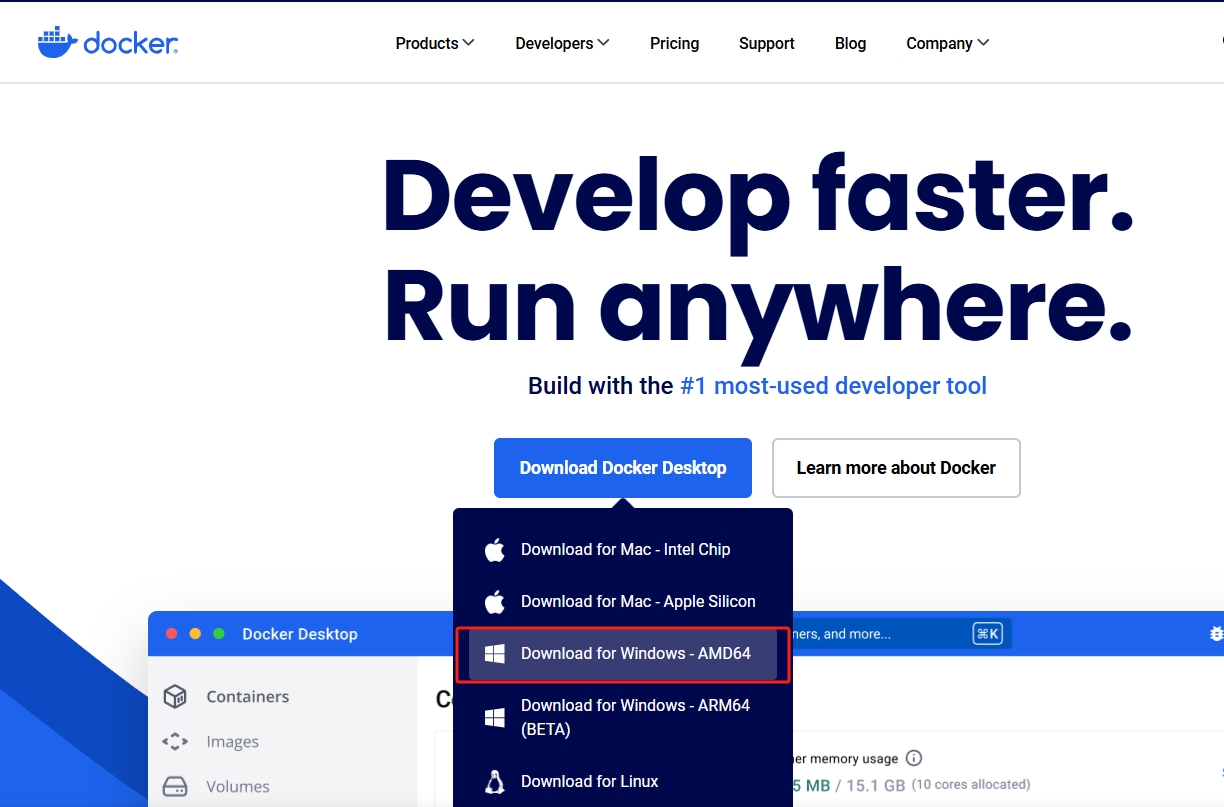

安装 Docker

安装 Docker 是为安装 Open-WebUI,如果你本地已经安装了 Docker 已经安装了 Docker 可以跳过本章节。

在安装 Docker 过程中最好在机器上运行科学上网。

前往 Docker 官网下载安装包

下载完成后双击安装 Docker 安装包,安装过程中最好勾选 Docker 官方推荐的选项,可以减少较多的配置操作。

验证安装

打开 CMD 输入docker --version命令查看版本信息,如果能够正常输出版本信息即表示安装完成。

安装 Open-WebUI

需要科学上网环境,否则 docker 的镜像包拉取会失败

Ollama 就在本地机器的话,可以执行如下命令安装并运行 Open-WebUI

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main |

如果本地有 Nvidia 显卡的话,可以运行如下命令:

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui-gpu --restart always ghcr.io/open-webui/open-webui:cuda |

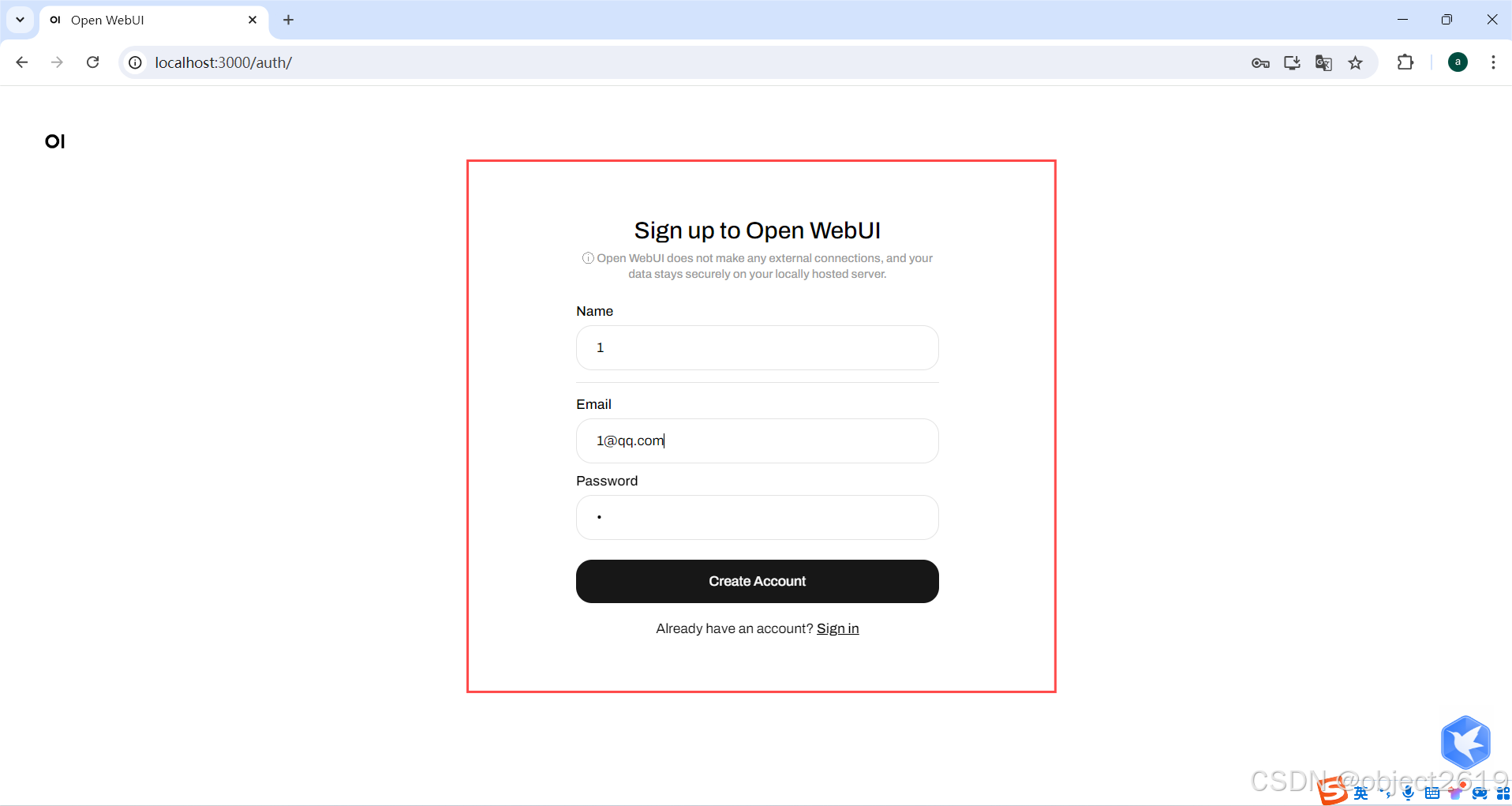

当 docker 镜像拉取完毕并启动后,可以在浏览器中输入 http://localhost:3000/ 来访问 Open-WebUI。

首次登陆 Open-WebUI,会提示新建用户,需要输入名称、邮箱和密码。邮箱可以随便写并不会进行验证邮箱有效性。

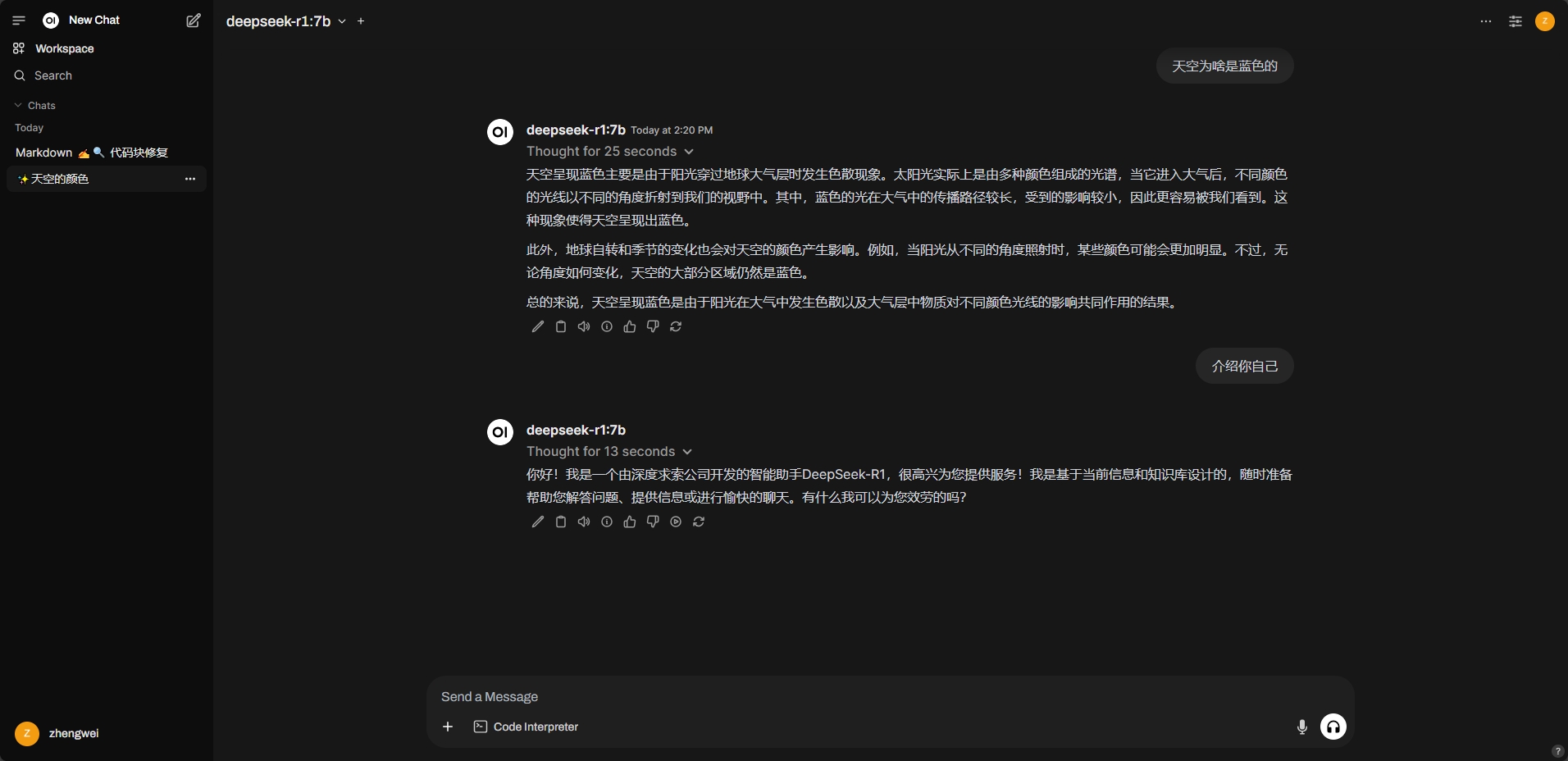

接下来就可以尽情的聊天了。

不仅可以在本机访问 Open-WebUI,本地局域网中的其他设备也能通过 http://本机IP:3000/ Open-WebUI 进行访问 Ollama DeepSeek-R1 模型。