【保姆级教程】在 macOS 上本地部署大模型并通过 OpenWebUI 进行访问

前言

在之前已经写过一份 Windows 部署 DeepSeek-R1 的博客了,但我那台陪我8年的 Windows 老伙计笔记本已经英勇牺牲了,正好乘着国补和教育补贴拿下 32G 内存、256G 硬盘的 Mac mini,也算是鸟枪换炮了。

这就导致了我之前部署的 DeepSeek 环境也用不了了,这不又来折腾 macOS 的 DeepSeek 的大模型环境

在本教程中,我们将手把手教你如何在 macOS 上部署 DeepSeek-R1 大模型,并通过 OpenWebUI 进行访问。本教程适合零基础用户,确保每一步都清晰可操作。

环境准备

安装 Ollama

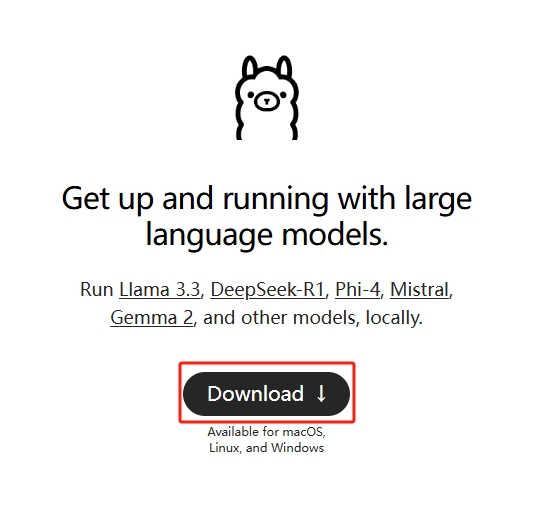

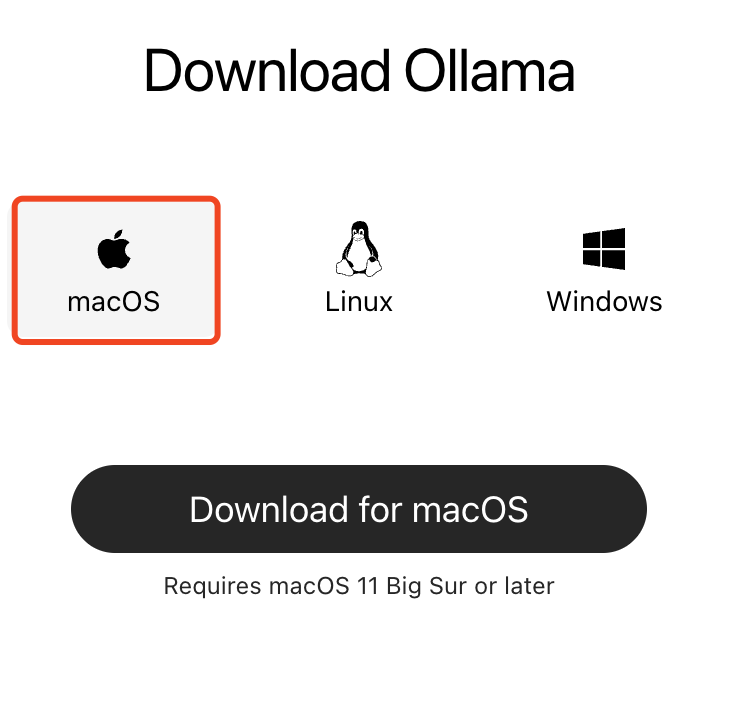

首先访问 Ollama 官网 来下载 Ollama 安装包

Ollama 官方 GitHub 源代码仓库:https://github.com/ollama/ollama

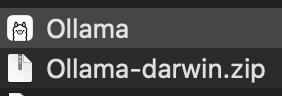

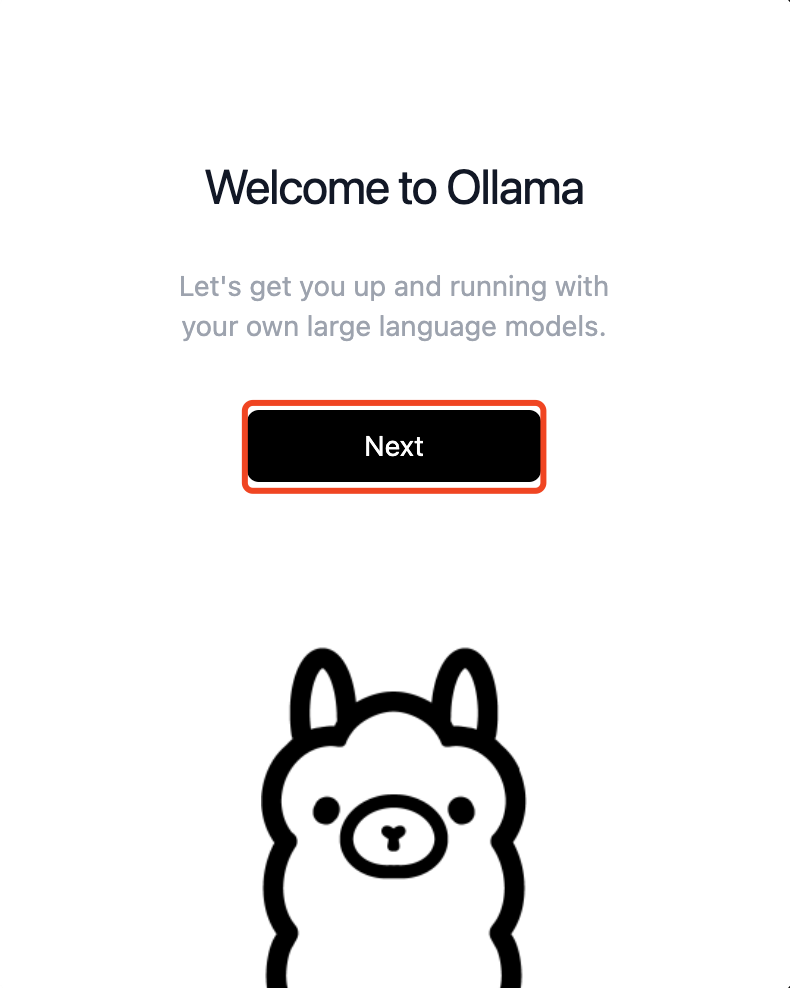

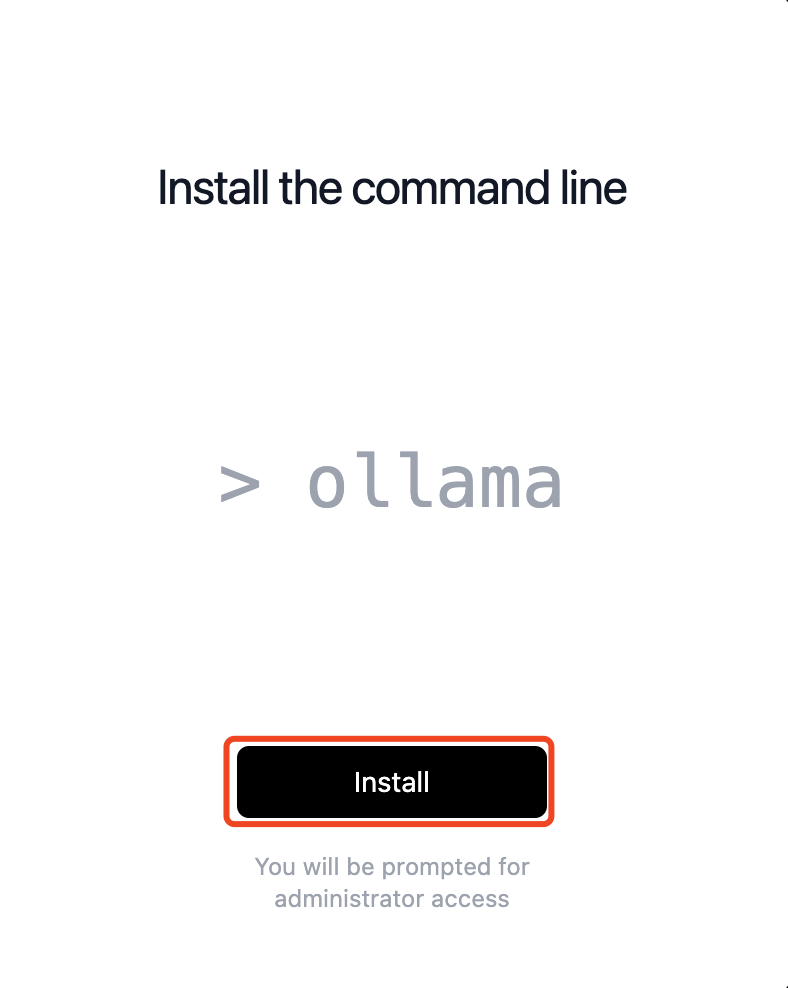

等待 Ollama 下载完成,待 Ollama 下载完毕之后双击打开压缩包解压出 Ollama 的安装文件

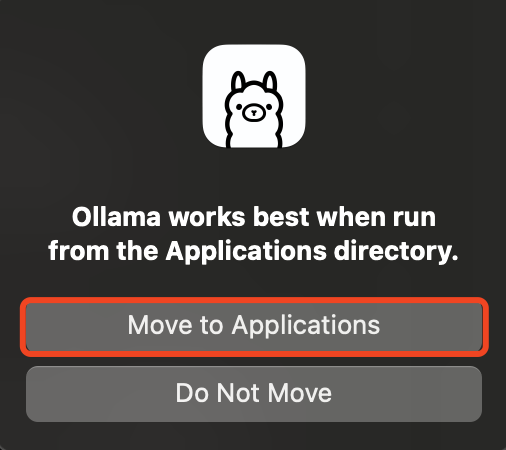

双击

Ollama安装文件进行安装

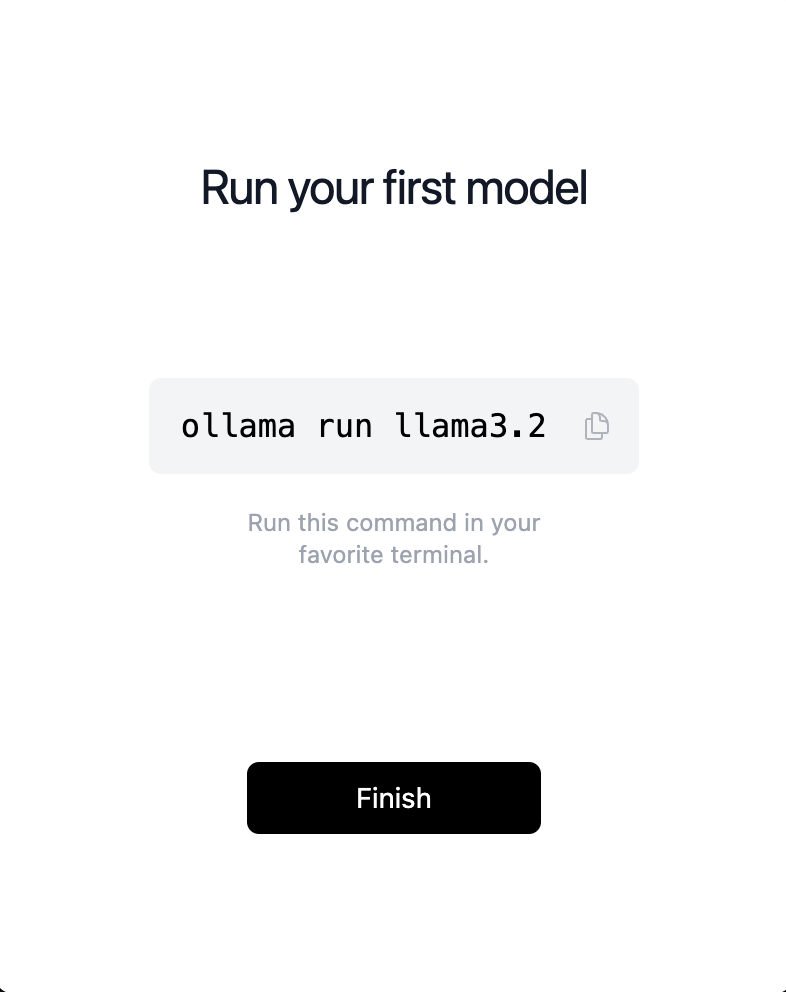

验证是否安装成功,在终端输入

ollama --version如果能正确输出版本号则说明安装成功配置 Ollama (可选)

- 在 macOS 上 ollama 默认将模型存放的路径是:

~/.ollama/models,如果想要修改此配置需要修改环境变量,使用launchctl setenv OLLAMA_MODELS "/Users/YourUsername/CustomOllamaModels"来更新环境变量的值 - 请将

/Users/YourUsername/CustomOllamaModels替换为实际的路径 - 如果你已有模型,那么可以将现有的模型迁移至新的目录中,使用

cp -R ~/.ollama/models/* /Users/YourUsername/CustomOllamaModels/命令来进行迁移 - 迁移之后需要重启 Ollama,重启之后新配置将会生效

- 同理,如果想修改

OLLAMA_HOST,OLLAMA_PORT等参数的话,也是使用以上的步骤进行修改即可

- 在 macOS 上 ollama 默认将模型存放的路径是:

安装 docker

首先访问 docker 官网下载 docker 安装包,等待安装包下载完毕。

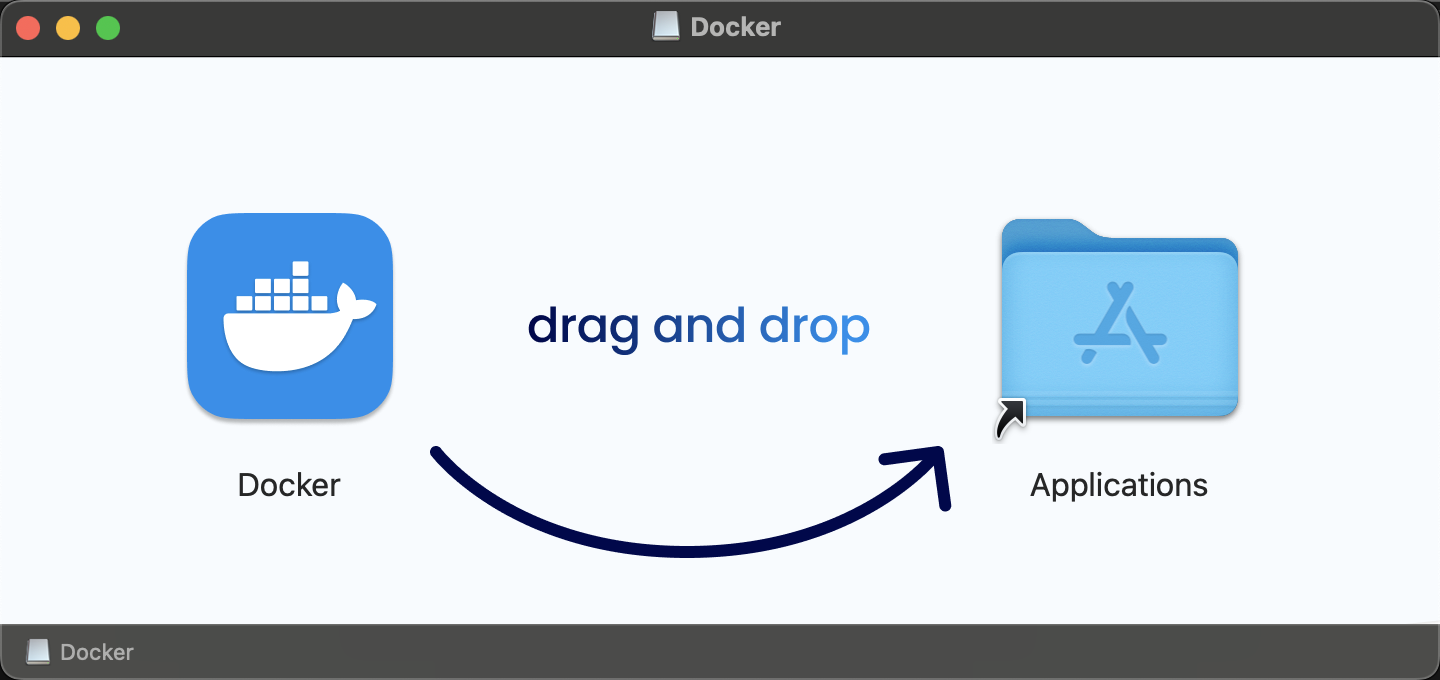

找到下载好的

Docker.dmg并拖拽到应用程序目录完成安装

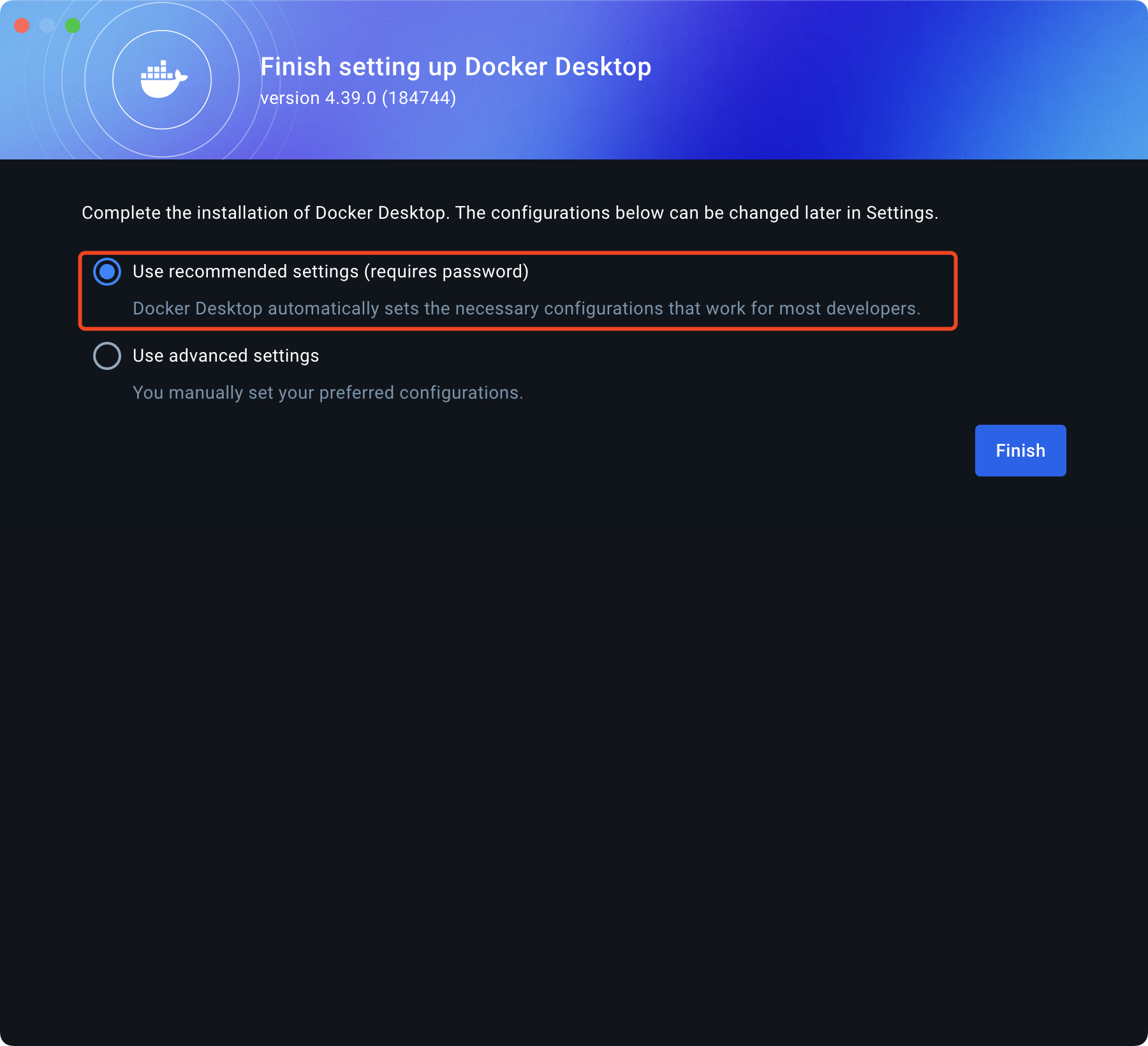

打开 docker,首次打开需要进行设置

跳过登陆

安装 OpenWebUI

需要科学上网环境,否则 docker 的镜像包拉取会失败

Ollama 就在本地机器的话,可以执行如下命令安装并运行 OpenWebUI

docker pull ghcr.io/open-webui/open-webui:main |

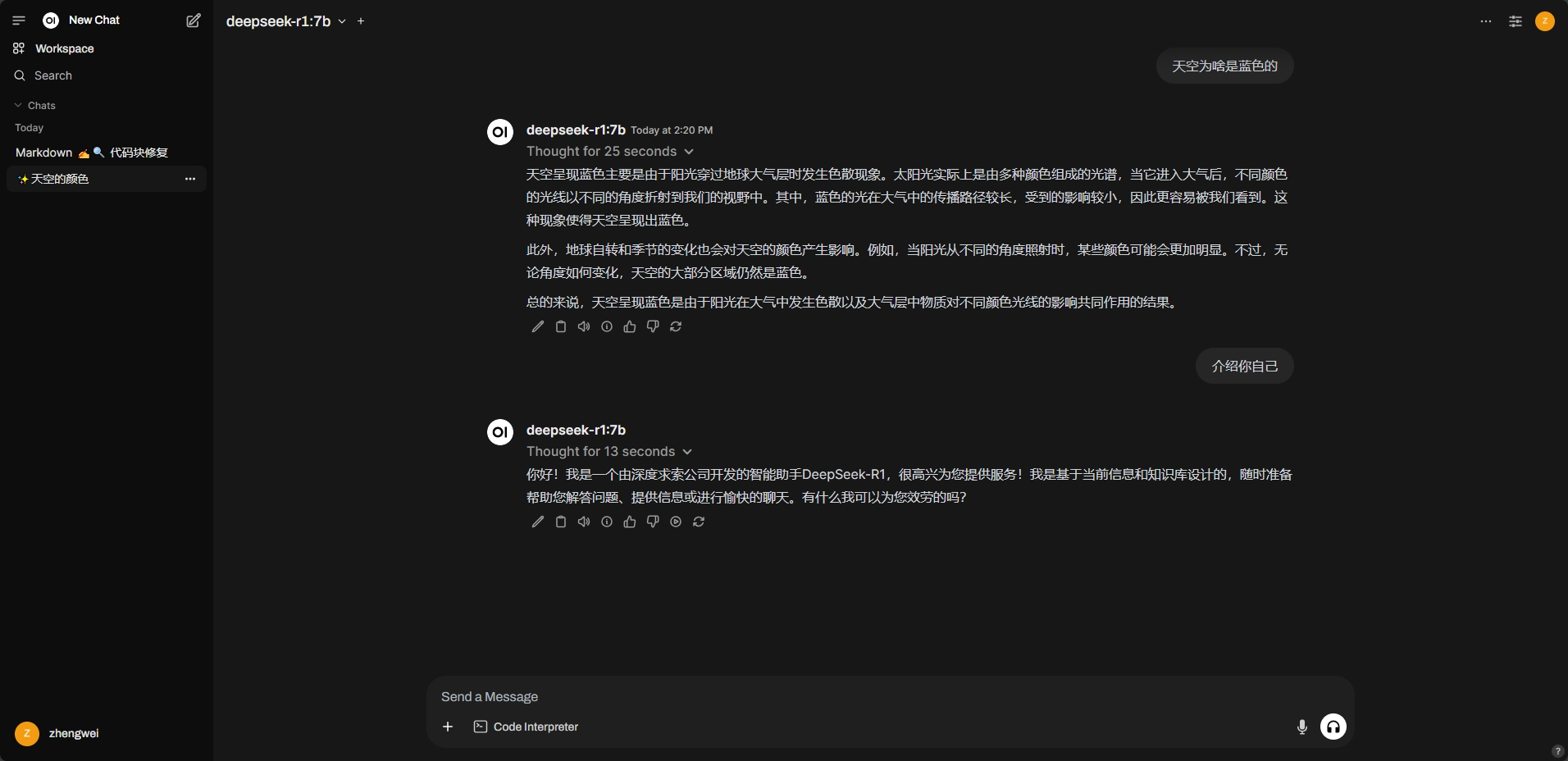

启动完毕之后即可访问 http://localhost:3000 来访问 OpenWebUI 界面

当然也可以在手机中访问 OpenWebUI 的界面

总结

这篇博客只是展示了如何部署 DeepSeek-R1 模型,Ollama 支持多种模型,我们只需要通过 Ollama pull 下到本地即可使用。